오랜만에 TED 강연 하나 소개할까 한다. 오늘은 최근 인공지능 기술 발전에 있어 정말 커다란 역할을 한 ImageNet 을 만든 스탠포드 대학의 페이페이 리(Fei-Fei Li)의 강연이다. 모두들 기술 그 자체를 개발하거나 어딘 가에 적용한 사람들만 조명하지만, 이런 기술의 발전에는 뒤에서 묵묵히 지루한 작업을 해낸 이런 숨은 영웅들이 큰 역할을 했다.

페이페이 리가 원했던 것은 컴퓨터 비전의 혁신이었다. 모라벡(Moravec)의 패러독스로도 유명한 개와 고양이를 구별하는 것조차 제대로 하지 못하는 컴퓨터에게 그림을 보고 그것을 제대로 인지하고 설명하도록 하는 것은 최근까지 풀어내지 못한 큰 도전이었다. 컴퓨터 비전 기술이 발전하지 못한다면 무인자동차가 카메라가 있어도 도로 위에 있는 장애물을 구별하지 못할 것이며, 드론이 하늘을 날며 촬영한 열대우림에 무슨 변화가 있는지 알아낼 수 없고, 감시카메라가 있어도 수영장에서 물에 빠진 아이를 보고서도 우리에게 경고를 해주지 못할 것이다.

카메라는 사진을 찍을 수 있고 센서에 들어오는 빛을 숫자의 2차원 배열인 픽셀로 변환할 수 있지만, 이는 그저 죽은 숫자이다. 카메라는 사진을 ‘찍을’ 수는 있지만 ‘보지’는 못하는 것이다. ‘본다’는 말에는 ‘이해한다’는 뜻이 있는데, 이것을 못하는 것이다. 사실 자연은 5억 4천만 년에 걸쳐서 시각을 발전시켜 왔다. 그 대부분의 시간은 우리 뇌의 시각처리능력을 발달시키는데 들어갔지, 눈을 만드는데 소요된 것이 아니다. ‘본다’는 것은 눈에서 시작되지만 이 현상이 가장 크게 발현되는 것은 우리의 뇌이다.

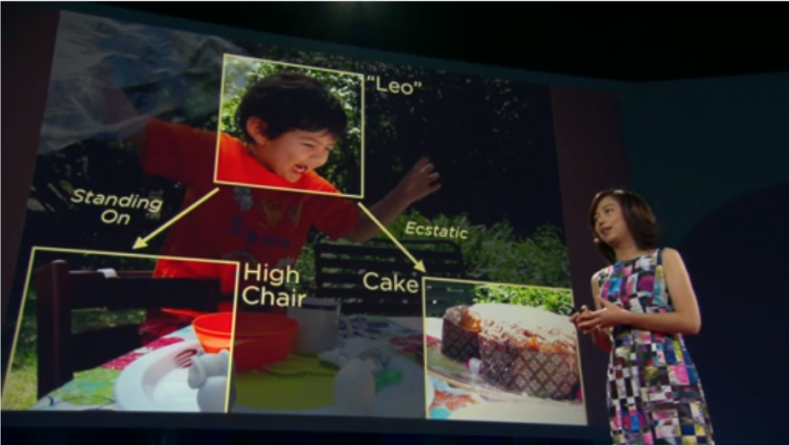

페이페이 리는 스탠포드 대학의 컴퓨터 비전 연구실을 이끌고 있는데, 컴퓨터로 하여금 어떻게 ‘보게’ 만들 것인지 연구해왔다. 카메라가 인식한 영상에서 물체와 사람을 식별하고, 3차원 도형의 구조를 추측하고, 관계, 감정, 행동과 의도를 이해하게 하는 것이다. 우리는 영상을 보면 이런 것을 순식간에 할 수 있지만, 컴퓨터에게 이런 작업을 시키려면 가장 먼저 사물과 시각 세계의 구성요소를 보고 분류하는 것에서 시작해야 한다. 그런데, 컴퓨터에게 이 작업이 쉽지가 않다.

예를 들어 컴퓨터에게 ‘고양이’ 사진을 보여줬다고 하자. 고양이는 모양과 색깔의 집합인데, 처음에는 고양이가 둥근 얼굴을 가지고 통통한 몸과 두 개의 뾰족한 귀, 그리고 긴 꼬리가 있다고 가르칠 수 있을 것이다. 이런 것을 객체 모델이라고 부른다. 그런데, 몸을 말고 있는 고양이라면 어떨까? 또 고양이가 숨어 있다면? 집안의 애완동물처럼 단순한 사물조차 객체 모델에는 무한한 변형이 존재할 수 있다.

그렇다면, 아이들은 어떻게 보는 법을 배우게 되는 것일까? 아이에게 보는 법을 가르칠 수는 없을 것이다. 아이들은 현실세계의 경험과 사례로 보는 법을 배운다. 만약 아이의 눈을 생물학적 카메라 한쌍이라고 하면 눈이 움직이는 평균 시간인 200밀리초마다 한 장씩 사진을 찍는 셈이다. 아이들은 세 살까지 수억 장의 현실세계 사진을 보게 된다. 방대한 양의 학습사례가 축적되는 것이다. 그렇다면, 이런 방식으로 컴퓨터에게 보는 법을 가르칠 수 있지 않을까? 이런 생각으로 2007년부터 페이페이 리는 프린스턴 대학의 카이리 교수와 이미지넷(ImageNet) 프로젝트를 시작했다.

이들은 인터넷과 집단지성의 힘을 적극적으로 활용하였다. 거의 10억 장에 이르는 이미지를 다운로드했고, 아마존의 MTurk(미캐니컬 터크)와 같은 크라우드 소싱 기술을 사용해 이미지에 레이블(label)을 붙였다. 5만명 가까운 작업자가 세계 167개국에서 약 10억 장의 후보 이미지정리 분류 작업을 도왔다. 지금이야 이렇게 답이 있는 방대한 빅데이터가 인공지능 기술의 발전에 얼마나 큰 영향을 미치는지 다들 알고 있지만, 페이페이 리 등이 작업을 하던 2007년의 분위기는 그렇지 않았다고 한다. 동료 교수들은 종신교수가 되려면 논문을 쓸 수 있는 다른 프로젝트를 하라고 조언했고, 연구자금도 모자랐다. 심지어 페이페이 리가 대학을 다닐 때 학비를 마련하기 위해 했던 세탁소 일을 다시 해야 되겠다는 생각도 했다. 그렇지만, 이들은 포기하지 않고 작업을 계속해서 2009년에 객체와 사물을 2만 2천 개의 범주로 분류한 1500만 장의 미이지 데이터베이스를 공개하기에 이른다. 예를 들어, 고양이의 경우 6만 2천 장의 이미지가 다양한 모양과 자세, 집고양이부터 들고양이까지 모든 종류를 망라한 사진들을 이미지넷에서 만나볼 수 있다. 그리고, 이 방대한 이미지 데이터베이스를 모든 사람들이 활용할 수 있도록 무료로 공개하였다.

그 결과 이미지넷의 풍부한 정보는 딥러닝 기술과 만나면서 오늘날의 딥러닝 전성시대를 열게 만드는 가장 중요한 영양분을 공급한 기초가 되었다. 이미지넷의 방대한 데이터와 현대의 CPU와 GPU의 발전에 힘입어 딥러닝 기술이 탑재된 컴퓨터는 우리에게 사진에 고양이가 있는지, 어디에 있는지 말해줄 수 있게 되었다.

여전히 컴퓨터는 실수를 저지른다. 그렇지만, 방대한 학습 데이터는 컴퓨터의 실수를 줄이고, 미래에는 더욱 다양한 일을 할 수 있게 만들 것이다. 의사들은 쉬지 않는 컴퓨터의 눈을 이용해 환자를 진단할 수 있을 것이고, 자동차는 더 똑똑하고 안전하게 도로를 주행할 것이다. 또한, 재난 지역에서 갇히고 부상당한 사람을 구할 수 있을 것이고, 새로운 종, 더 나은 물질을 발견하고 보지 못한 개척지를 탐험하게 될 것이다. 이런 과정을 통해 우리는 기계가 ‘보는’ 것을 가능하게 만들고 있는 것이다.

그녀의 마지막 말이 인상적이다.

“우리는 기계에게 보는 것을 가르쳤습니다. 다음엔 기계가 우리를 도와 더 잘 보게 할 겁니다. 처음으로, 인간의 눈이 아닌 것이 세계를 생각하고 탐험하게 되었습니다. 우리는 인공지능 때문에 기계를 이용할 뿐만 아니라 상상치 못했던 방식으로 기계와 협력하게 될 것입니다”

멋진 그녀의 TED 강연을 한번 보도록 하자. [ted id=2218 lang=ko]

글 : 하이컨셉

You must be logged in to post a comment.